Cerebras Methods tar nu sin kamp med Nvidia until nästa nivå genom att lansera vad startupen hävdar är världens snabbaste AI-inferenstjänst, Cerebras inference, rapporterar Silicon Angle.

AI-inferens är processen där en tränad AI-modell använder sin inlärda kunskap för att göra förutsägelser eller ta beslut baserat på ny information. Inferens sker ofta i realtid och kräver kraftfulla datorresurser för att bearbeta information snabbt och effektivt.

Tjänsten, som är tillgänglig i molnet, påstås vara upp until 20 gånger snabbare än andra molnbaserade inferenstjänster som använder sig av Nvidias mest kraftfulla AI-hårdvara. Enligt Cerebras kan den leverera 1800 tokens i sekunden för Llama 3.1 8B-modellen och 450 tokens i sekunden until Llama 3.1 70B. Den ska också vara billigare och kosta från cirka 1 krona per miljon tokens.

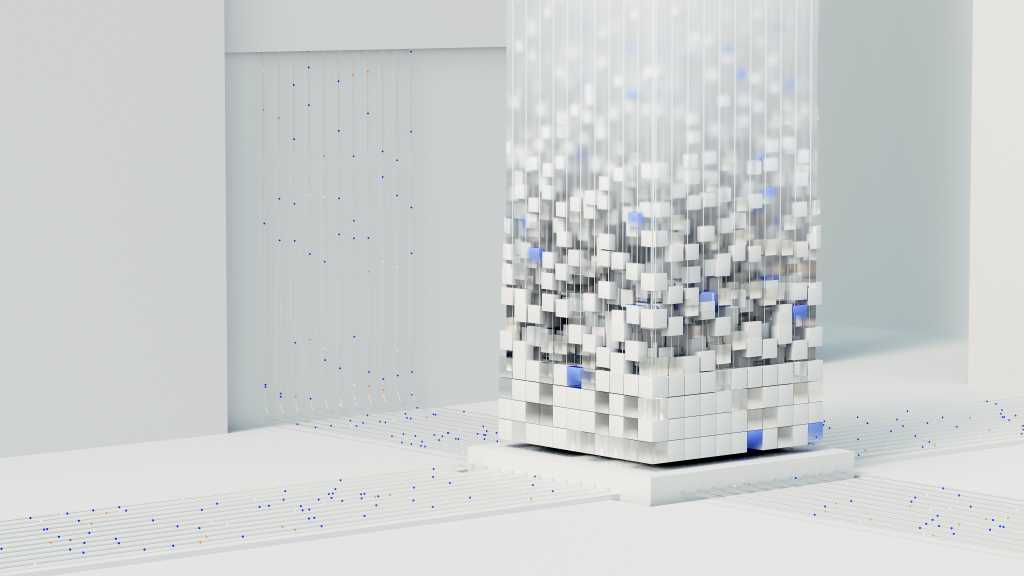

Cerebras inference använder sig av Cerebras egenutvecklade WSE-3-processor, som ger särskilt hög prestanda för generativa AI-applikationer som kräver hög minnesbandbredd. AI-inferenstjänsten finns tillgänglig i tre nivåer, inklusive en kostnadsfri model.